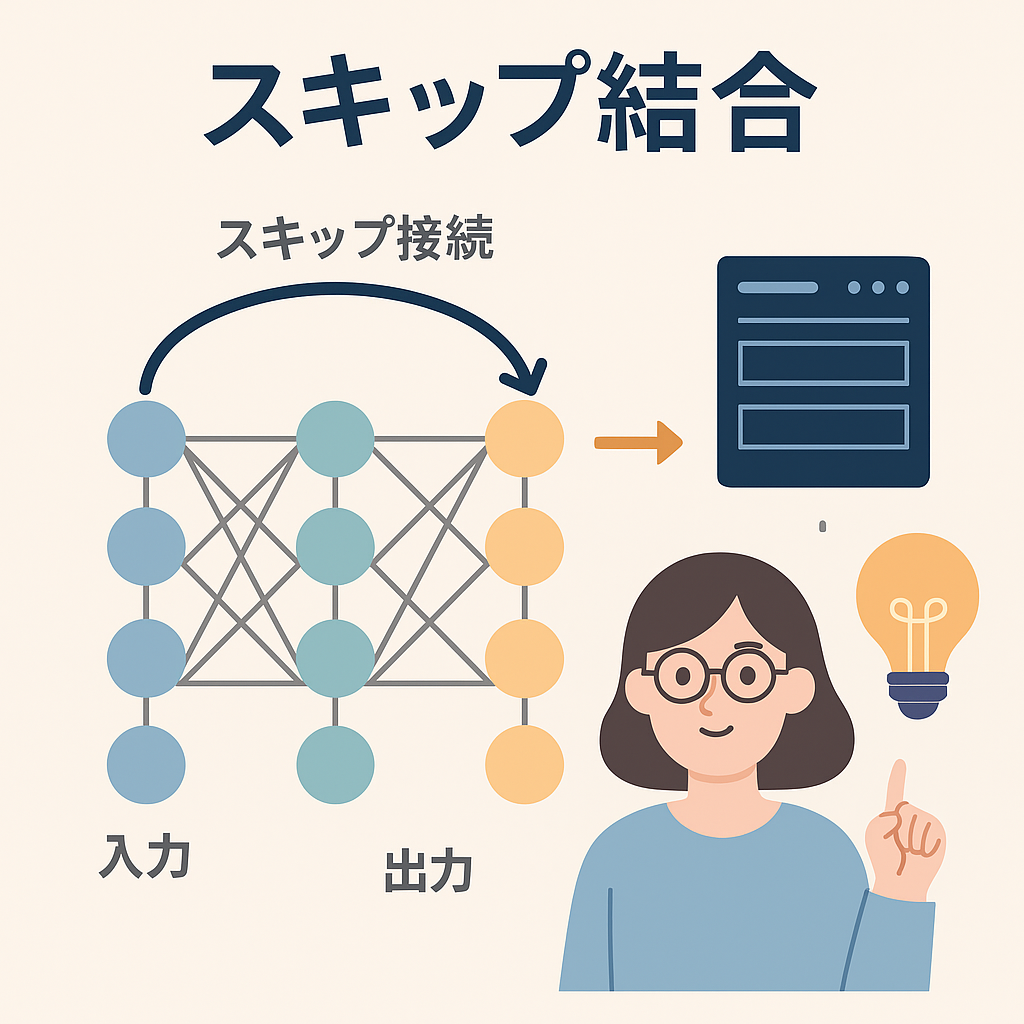

■ 概要

スキップ結合(Residual Connection)は、深層学習モデル、とりわけ「ResNet(Residual Network)」の中で登場した技術です。入力をそのまま次の層に渡す「ショートカット経路」を作ることで、深く層を重ねても「学習が進まなくなる」という問題を緩和します。

■ なぜ登場したか

深層学習は、層を深くすると性能が上がると考えられてきましたが、現実には「深くすると逆に性能が劣化する」「学習が収束しない」という問題がありました。

これを「勾配消失問題(Vanishing Gradient Problem)」と呼びます。

ResNetは、スキップ結合によってこれを解決し、非常に深いネットワークでも学習を安定させ、高精度を実現しました。

■ 仕組み

スキップ結合は「層の出力(通常の変換結果)」と「変換せずにそのまま通した入力」とを足し合わせる仕組みです。

これにより、情報が劣化せず次の層へ伝わるため、深いネットワークでも学習が続けやすくなります。

数式で表すと次のようになります:

- 通常:

y = F(x) - スキップ結合:

y = F(x) + x

ここで、F(x)は畳み込みや活性化関数などの変換処理を意味し、xはスキップして足される元の入力です。

■ どんなときに使われるか

- 画像認識(ResNet、Wide ResNet)

- 物体検出(Faster R-CNN)

- 画像セグメンテーション(U-Net)

- 大規模言語モデル(Transformerでも応用されている)

■ 業界的な背景

ResNetが2015年にImageNetコンペティションで優勝し、深いネットワークの実用化に道を開きました。この成果は、その後の自然言語処理や音声処理など、さまざまなモデルアーキテクチャに影響を与えています。

Transformerも、スキップ結合を応用して安定した学習を実現しており、LLMやChatGPTのような大規模モデルにもつながっています。

コメント